Praktischer Einstieg in KI-App-Entwicklung

KI-App Entwicklung mit Python, Ollama & Streamlit

In diesem 4-tägigen Programmierkurs (mit einem optionalen Zusatztag am Anfang für Python und Streamlit Grundlagen) begleite ich Dich auf Deinem Weg in die Entwicklung eigener KI-Anwendungen.

Gemeinsam starten wir mit einem Einführungstag zu Python und Streamlit, sodass Du schnell die wichtigsten Grundlagen beherrschst.

An den folgenden vier Tagen setzen wir Schritt für Schritt spannende KI-Projekte um:

Du

- entwickelst einen Chat-Client mit lokalem KI-Modell,

- baust eine Bildanalyse-App,

- erstellst ein Tool zur automatischen Blog-Gliederung,

und - programmierst eine Anwendung für Zusammenfassungen und Quizfragen zu Deinen Wunschthemen.

Dabei lernst Du, wie Du Ollama in Deine Projekte einbindest, Prompts richtig formulierst und mit Streamlit interaktive Oberflächen gestaltest.

Am Ende des Kurses hast Du nicht nur das Wissen, sondern auch fertige Beispiele in der Hand, mit denen Du Deine eigenen Ideen weiterentwickeln kannst.

Hier nochmals die Zeitlanung:

- 08.11: Zusätzlicher Einführungstag – Crashcourse in Python und Streamlit

- 15.11

- 13.12

- 10.01

- 24.01

Installationsanleitung

Python 3.11 · VS Code Insiders · Ollama · Streamlit

Diese Anleitung zeigt Schritt für Schritt, wie Du Deine Entwicklungsumgebung für den Kurs einrichtest.

Du lernst, Python 3.11, VS Code Insiders, Ollama und Streamlit zu installieren und mit einer virtuellen Umgebung zu arbeiten.

Voraussetzungen

- Ein Terminal (macOS: Terminal, Windows: PowerShell, Linux: Konsole)

- Administratorrechte für Softwareinstallationen

- Ca. 15 – 20 GB freier Speicherplatz

Python 3.11 installieren

- Windows

- Linux

- Mac OS

winget install "Python.Python.3.11" py -3.11 --version

Wenn der Befehl nicht gefunden wird, PowerShell neu starten.

sudo apt update sudo apt install -y software-properties-common sudo add-apt-repository ppa:deadsnakes/ppa -y sudo apt update sudo apt install -y python3.11 python3.11-venv python3.11-distutils python3.11 --version

brew install python@3.11 python3.11 --version

Alternative: Installer von https://www.python.org/downloads/

Falls Build-Tools fehlen:

xcode-select --install

Git Installieren

- Windows

- Linux

- Mac OS

winget install "Microsoft.Git"

sudo apt update sudo apt install git

brew install git

Ollama installieren

- Windows

- Linux

- Mac OS

winget install "Ollama.Ollama" ollama --version

curl -fsSL https://ollama.com/install.sh | sh ollama --version

brew install ollama ollama --version

VS Code Insiders installieren

- Windows

- Linux

- Mac OS

winget install "Microsoft.VisualStudioCode.Insiders"

Lade das `.deb`- oder `.rpm`-Paket von

https://code.visualstudio.com/insiders

oder nutze deinen Paketmanager.

brew install --cask visual-studio-code@insiders

Empfohlene Erweiterungen

- Python (Microsoft)

- Pylance (IntelliSense)

- Optional: Black, autopep8, Ruff

Dienst starten

ollama serve

Modell herunterladen und testen

ollama pull phi4

ollama run phi4 >>> Wieviel is 2+2? >>> /exit

Projektordner und Virtuelle Umgebung

- Windows

- Linux

- Mac OS

C: cd \ mkdir Enrichment cd Enrichment

git clone https://github.com/r14r/Enrichment_AI-App .

pwd

Der angezeigte Name ist das Verzeichnis, in dem wir in diesem Kurs arbeiten. Bitte Merken

py -3.11 -m venv .venv

mkdir -p ~/Enrichment cd ~/Enrichment

git clone https://github.com/r14r/Enrichment_AI-App .

pwd

Der angezeigte Name ist das Verzeichnis, in dem wir in diesem Kurs arbeiten. Bitte Merken

python3.11 -m venv .venv

mkdir -p ~/Enrichment cd ~/Enrichment

git clone https://github.com/r14r/Enrichment_AI-App .

pwd

Der angezeigte Name ist das Verzeichnis, in dem wir in diesem Kurs arbeiten. Bitte Merken

python3.11 -m venv .venv

Aktivieren

- Windows

- Linux

- Mac OS

.\.venv\Scripts\Activate.ps1 python --version

source .venv/bin/activate python --version

source .venv/bin/activate python --version

pip und Tools aktualisieren

pip install --upgrade pip

Installation über requirements.txt

pip install -r requirements.txt

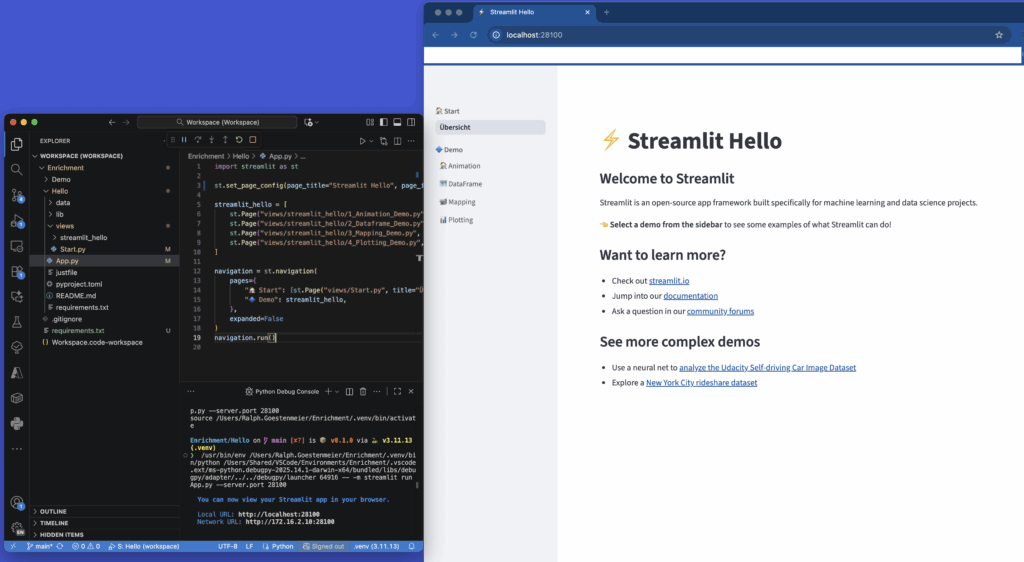

Streamlit testen

streamlit hello

Ein Browserfenster öffnet sich – Streamlit funktioniert! ✅

VS Code starten

- Windows

- Linux

- Mac OS

cd \Enrichment code-insiders Workspace.code-workspace

cd ~/Enrichment code-insiders Workspace.code-workspace

cd ~/Enrichment code-insiders Workspace.code-workspace

Wichtig:

Beim Aufruf den Dateinamen nicht vergessen: Workspace.code-workspace

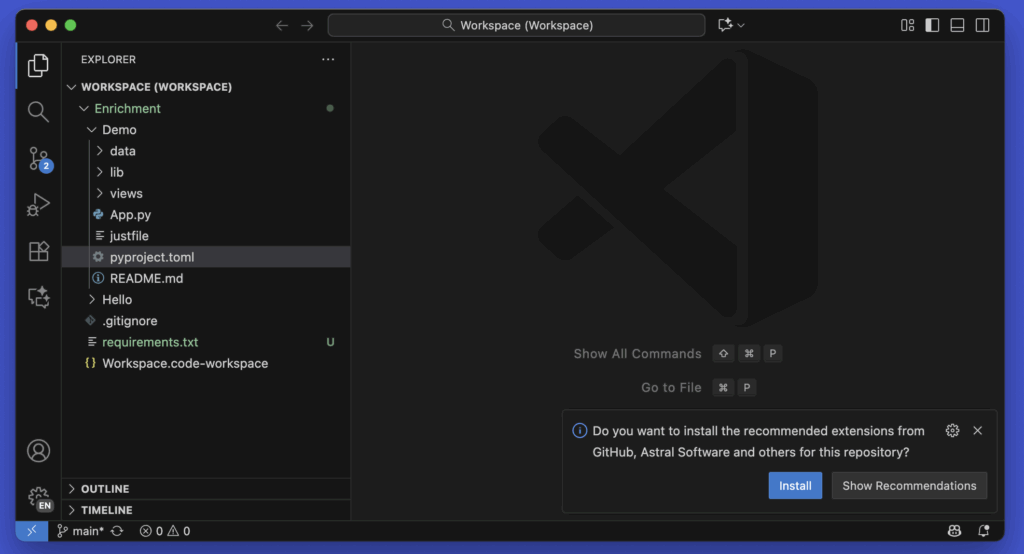

Es öffnet sich VS Code.

Nach einer kurzen Zeit solltest du rechts unten den Hinweis sehen, das du empfohlene Extensions installieren kannst.

Klicke bitte hierzu auf INSTALL

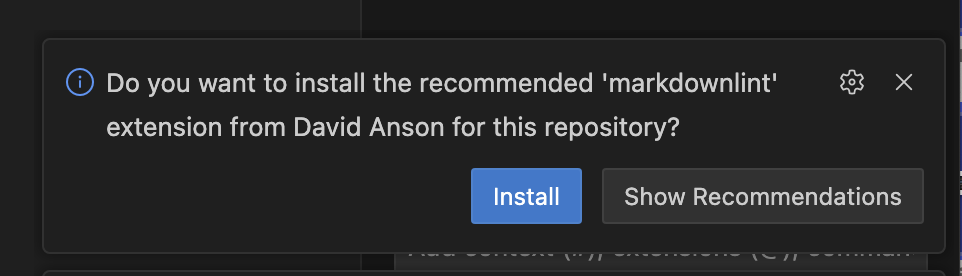

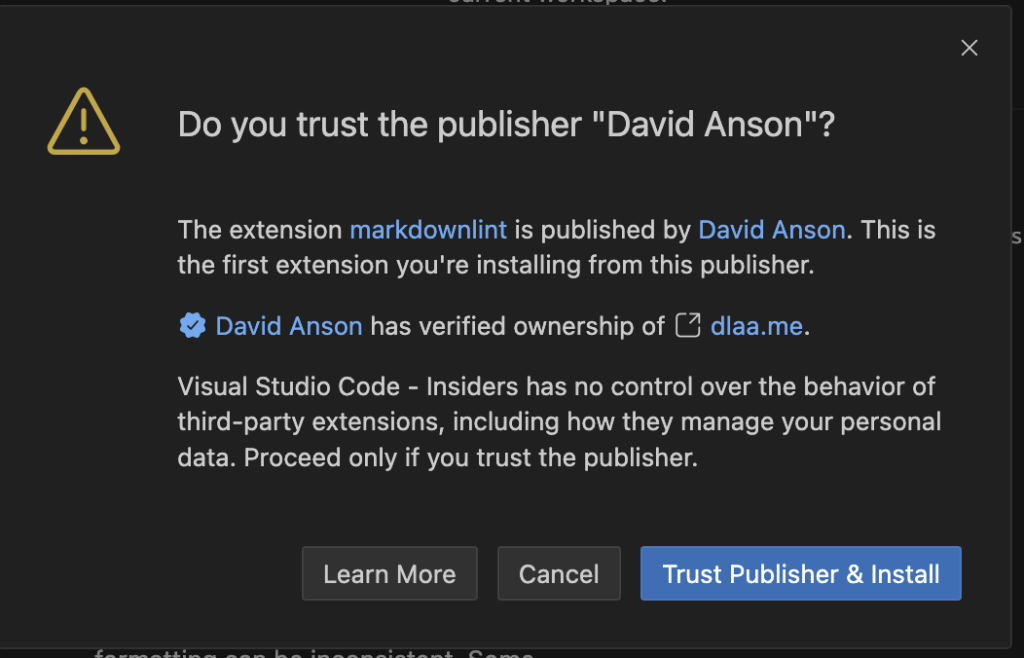

Es kommt dann eine Nachfrage, ob du den Installationsquellen vertraust.

Klicke ebenfalls auf OK

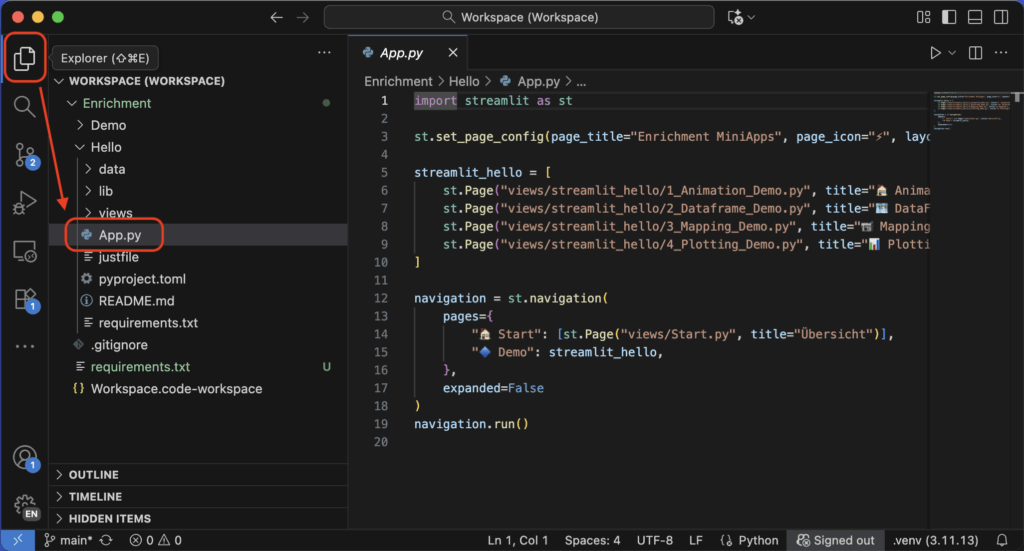

Nachdem du dann alle Register der installierten Extensions geschlossen hast, solltest Du dieses Fenster sehen. Klicke hierzu auf den Namen eines Registers mit der Rechten Maustaste und wähle „Close All“

Klicke hierzu auch auf der linken Seite zuerst auf das Symbol um alle Dateien anzuzeigen, und dann auf die Datei Hello/App.py

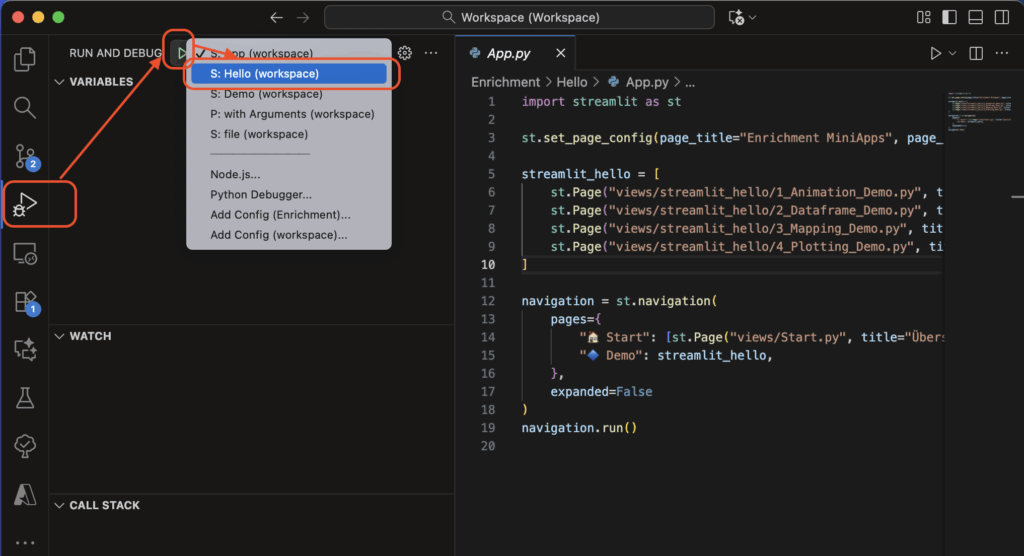

Streamlit aus VSCode starten

- Klicke auf das Symbol für „Run and Debug“

- Klicke in der Kopfzeile neben dem „RUN AND DEBUG“ auf den Text neben dem grüne Dreieck

- Selektiere dann „S: Hello (workspace)

- Drücke die Taste

F5oder auf das grüne Dreieck

Wenn eine Antwort kommt, läuft alles richtig.

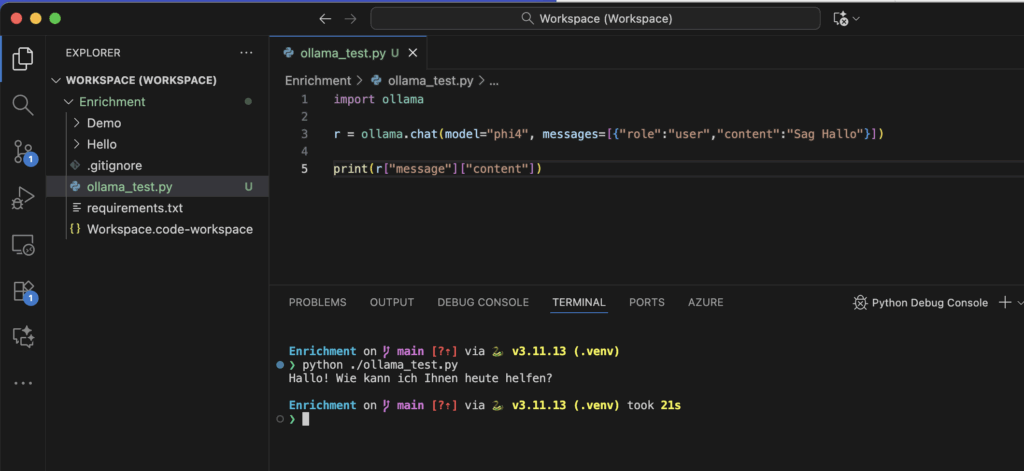

Test mit Python und Ollama

pip install ollama

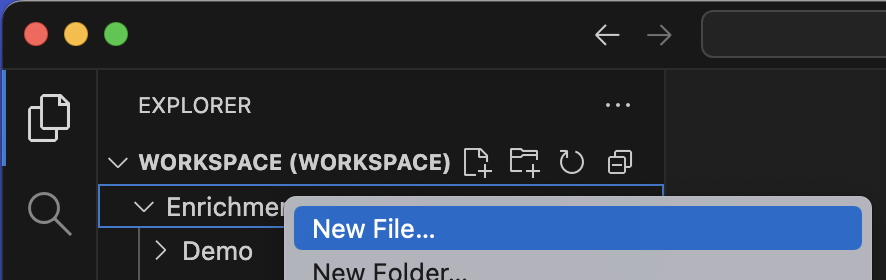

Dann erstelle die Datei ollama_test.py mit diesem Inhalt:

import ollama

r = ollama.chat(model="phi4", messages=[{"role":"user","content":"Sag Hallo"}])

print(r["message"]["content"])

Führe die Datei aus mit

python ollama_test.py

Oder innerhalb von VS Code. Zeige dazu ein Terminal an über den Menüpunkt View/Terminal

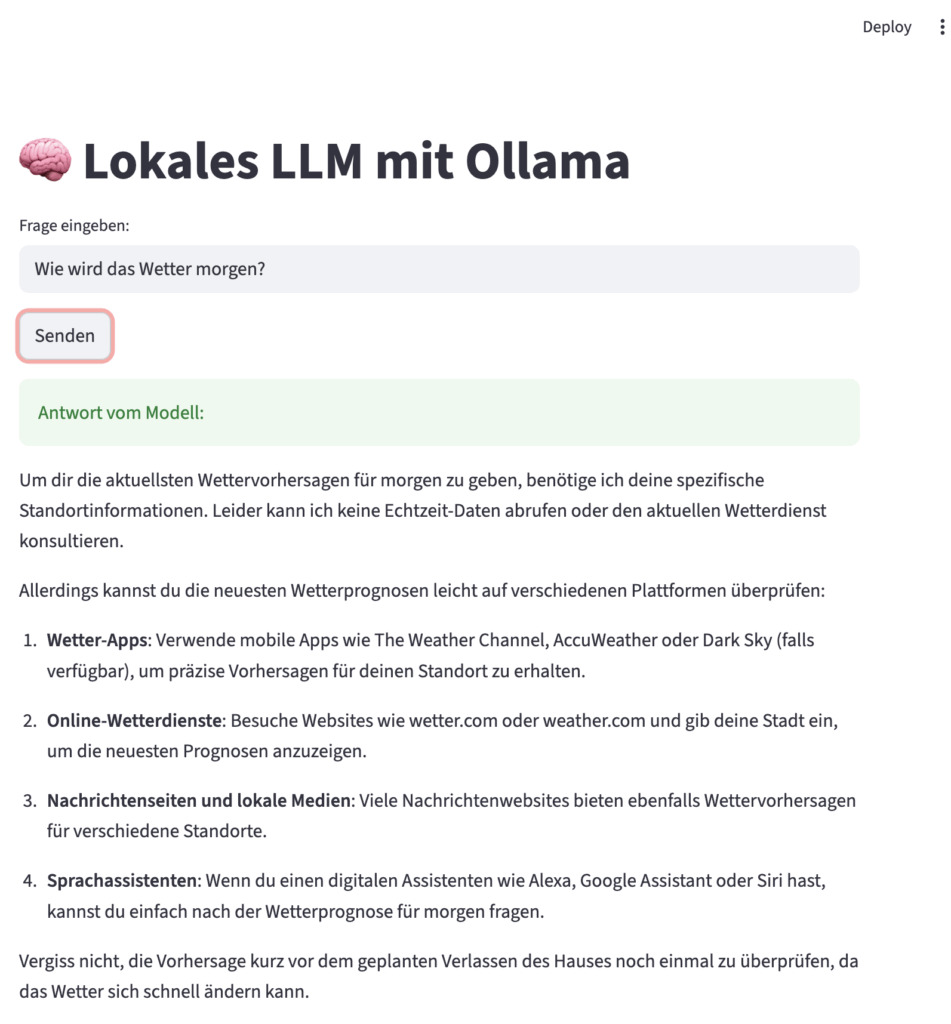

Streamlit + Ollama Beispiel-App

Erstelle die Datei ollama_app.py mit dem folgenden Inhalt:

import streamlit as st

import requests

st.title("🧠 Lokales LLM mit Ollama")

prompt = st.text_input("Frage eingeben:")

if st.button("Senden") and prompt.strip():

try:

with st.spinner("Warte auf Antwort..."):

response = requests.post(

"http://localhost:11434/api/generate",

json={

"model": "phi4",

"prompt": prompt,

"stream": False

},

timeout=600

)

if response.status_code != 200:

st.error(f"Fehler: {response.status_code} - {response.text}")

else:

data = response.json()

antwort = data.get("response") or data.get("message") or "Keine Antwort erhalten."

st.success("Antwort vom Modell:")

st.write(antwort)

except Exception as e:

st.error(f"Fehler: {e}")

Starten:

streamlit run ollama_app.py

✅ Wenn du eine Antwort siehst, funktioniert deine gesamte Umgebung!

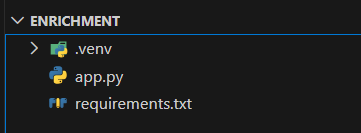

Typische Projektstruktur

Nächste Schritte

1. Python-Grundlagen im Kurs durcharbeiten

2. Streamlit-Apps erstellen und ausführen

3. Ollama-Modelle lokal nutzen und prompts testen

💬 Wenn du auf Fehler stößt:

Schreibe mir die vollständige Fehlermeldung + dein Betriebssystem + Python-Version – ich helfe dir gezielt weiter.

🧡 Viel Erfolg beim Start in dein KI-Projekt!